「コンテナ」ってなに?(1)〜仮想化が必要になった経緯

https://sapporomkt.blogspot.com/2019/10/1.html

「コンテナ」ってなに?(2)〜コンテナの技術的特長をザックリと。

https://sapporomkt.blogspot.com/2020/04/2.html

https://sapporomkt.blogspot.com/2019/10/1.html

「コンテナ」ってなに?(2)〜コンテナの技術的特長をザックリと。

https://sapporomkt.blogspot.com/2020/04/2.html

今回は、「Kubernetes(K8s)」の概略についてです。

着実に浸透する「Dockerコンテナ」。でも課題が・・・

IT関連の方々は日々お感じのことと思いますが、今、日本国内でも「コンテナ化」は着実に進んでいます。その重要キーワードの一つとして 「Kubernetes(K8s)」が注目されています。

IDCが2019年4月に日本国内の企業及び組織468社に対して行ったアンケートによると、何らかの形でコンテナに取り組んでいる割合は「47.6%」にも及んでいます。

※「本番環境で使用している」「導入構築/テスト/検証段階」「使用する計画/検討がある」「情報収集や勉強している」の総計として。

IDC Japan、2019年 国内Dockerコンテナ/Kubernetesに関するユーザー導入調査結果を発表

https://www.nikkei.com/article/DGXLRSP513611_T00C19A7000000/

https://www.nikkei.com/article/DGXLRSP513611_T00C19A7000000/

とはいえ、同スコアを2018年4月と比べると、-1.4%となっており、少々課題感がある状況も伺えます。

※「本番環境で使用している」「導入構築/テスト/検証段階」のトップ2合計だと、2019年は+3%となっています。

実際、「重要なテクノロジーであることは認識しているものの、「コンテナの仕組み」や「Dockerコマンド」などを学習する必要があるため、IT部門のワークリソースが十分でない企業にはハードルが高い部分もある」とお客様から伺ったことがあります。

世界の主流になることが確定?「Kubernetes」が登場!

そのようなコンテナの課題を解決するために、Googleが開発し、のちにオープンソースソフトウェアとな理、今尚進化を続けているのが、「Kubernetes(クーバネティス:K8s)」です。

それまでは開発者中心に使われていたコンテナを本番サービスでも使用するために生まれた「コンテナ・オーケストレーション」のすごい技術です。

どのくらいすごい技術かと言うと・・・

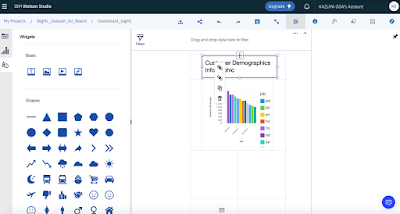

上記画像にある通り、世界の名だたるITベンダーさんがこの仕組みを支援する団体に入って応援しつつ、自社クラウドソリューションにK8sを組み込んで提供しています。そう、もう、デファクトなんです!

・・・って言う説明は荒っぽ過ぎるので、この辺り、IBM高良さんが出された本をご覧頂くとスムーズに理解できるのでオススメです(私もまだ勉強中ですが^^;)

ちょっとだけ真面目に記載すると、技術的には、セキュリティや可用性の向上など様々なメリットが期待できます。

なお、Kubernetesは、IBM Cloud上でも利用可能です。

上記高良さん本では、IBM Cloud上でのKubernetes利用についても紹介されています。

加えて、下記IBMサイトでもIBM Cloud上でのK8s/Istio/Watsonを使用したビルド方法が公開されていますので、ご興味ありましたらご覧ください。

以上です。

次回は、「OpenShift」について触れてみたいと思います。

「コンテナ」関連エントリー

https://sapporomkt.blogspot.com/2019/10/1.html

「コンテナ」ってなに?(2)〜コンテナの技術的特長をザックリと。

https://sapporomkt.blogspot.com/2020/04/2.html