(R言語)NHTSAから4行でテキストマイニング 用データをサンプリングする

https://sapporomkt.blogspot.com/2019/07/rnhtsa4.html

今回は、このデータセットを使って、IBMが誇るテキストマイニング ソリューションである「Watson Explorer(WEX)」用の分析データ(WEXでは「コレクション」と言います)を作成します。

実施環境については、以下の通りです。

・IBM Watson Explorer Deep Analytics Edition Version 12.0.2

※本エントリーは、私、小田一弥が一個人として勉強を兼ねて記載したものです。私の勤務先である日本アイ・ビー・エム株式会社の見解・見識ではない、個人としての記載内容としてご覧ください。

WEX Deep Analytics Edition(ver12)の概要

(そもそも「WEXってなに?」の方向けです。ご存知の方は、当パートは読み飛ばしてください)

詳細は、下記のWEX紹介ページをご参照ください。

簡単に言うと「人間が読みきれない大量の文献、文書、レポートを分類・分析して知見を獲得」するための、IBMのテキストマイニングソリューションです。

ウリとしては、下記5点ですが、特に、V12になって機械学習(AI含む)とUI/UXが大幅に強化されました。

1.ビッグデータ対応:

他社ソリューションでも数十万件レコードレベルなら対応可能と思いますが、WEXは数百万件レコードでも難なく分析するスケーラビリティを有しています。

(ただし、それに合ったシステム基盤が必要です)

2.高度な言語理解と深い洞察

同義語辞書だけではなく、様々な言い回しの意図も抽出可能な機能があります。

「IBM Watson Knowledge Studio(WKS)」を用いると、文章に注釈としてメタデータを付与し、WEX上で利用することができます。

3.多言語対応

もともと、日本IBMが開発したソリューションであるため、日本語の解析を得意としていますが、全部で16カ国もの多言語分析が可能です。

4.機械学習を用いた自動文書分類

V12から新たに機械学習を用いた分類機能が実装されました。

5.データに基づく分析ステップのガイド

テキストマイニング未経験者でも直感的に使えるUI/UXとなりました。

(初見だと、V11以前のユーザーは面食らうかもしれませんが、すぐ慣れると思います)

WEX Deep Analytics Edition(ver12)の概要

WEXに限らず、テキストマイニング ソリューションは、「文字コード指定」や「フィールド設定」など、分析着手までの作業負担が重くゲンナリすることが多いのですが、WEXはこの辺りの作業がかなり楽です。

下記に手順を記載しますが、ローデータのフィールドずれなどが無ければ、ほとんどポチポチとボタンを押せば完了するかと思います。

1.WEXにログインする

まずは、管理者から配布されたIDとPASSでログインしてください。

2.「コレクションを作成」を選択する

コレクション(WEXの分析対象となるデータ)一覧画面が表示されるので、「コレクションを作成」を選んでください。

3.「次へ」をそのまま選択する

既に「コンテンツ・マイニング」にチェックされているので、そのまま「次へ」を選択してください。

4.分析対象ファイルをアップロードする

画面下部のアップロードスペースに、前回サンプリングした分析対象ファイルをアップロードします(リンクをクリックしてのファイル選択でも可能です)。

5.コレクション名を記載する

アップロードが完了すると画面が切り替わるので、コレクション名を記載します。

なお、実務上は、ファセットのテスト用コレクションなど複数のコレクションを作ることが多いと思います。

「テスト/本番」や日付など、誰が見てもわかるコレクション名を記載するよう、習慣づけると良いと思います。

「説明」欄は、複数メンバーでの作業であれば記載してください。

6.「フィールド」画面が表示される

取り込みが完了すると、「フィールド」画面が表示されます。

「CSVプレビュー」の部分を見ると、各フィールドが自動的に識別されています。

あと、WEX V11と比べると、画面上段に「テンプレート」から「保存」までの作業ステップが明示されており、どのステップまで進んでいるかがわかりやすいですね。

7.「LDATE」を「日付」形式に変更する

「LDATE」がユーザーからクルマの異変を報告された日のため、このフィールドを「日付」に変更します。

すると、「LDATE」フィールドで取り込んだデータがグラフ化されます。

WEX V11までは、コレクション作成が全て完了しないと見れなかったため、これはとても助かりますね。特に、V11まで日付形式は鬼門で何度も取り込みを繰り返していたのでありがたいです。

また、右下の「フィールド・マッピング」では、分析対象となるテキスト本文が記載されているフィールド(「CDESCR」フィールド)が自動的に指定されています。

V11までは、「Body」フィールドとして都度指定が必要でしたが、随分と楽になりましたね。

8.「CSVパーサーの構成」をチェックする

「CSVプレビュー」パートの右上部分にある「CSVパーサーの構成」をクリックします。

文字コードや区切り文字の指定が可能です。今回のデータは変更は不要なので、このまま閉じて、「次へ」ボタンを押してください。

9.アノテーターを指定する

「コレクションのエンリッチ」画面に遷移します。

ここでは、非構造化データ(ここでは「CDESCR」フィールド)に様々なアノテーション(注釈)をつけることができます。

「アノテーション??」な方は、次回以降のエントリーで記載しますので、今は、「文章や単語に意味をつけて、分析に利用できるようにする」ぐらいのご理解でOKです。

ここでは、「評判分析」と「固有表現抽出」にチェックをつけて、「次へ」ボタンを押してください。

10.ファセットを指定する

分析用ファセットの指定画面に遷移します。WEXではデフォルトで様々な品詞や語句などを抽出可能です。実務的には色々とやることがあるプロセスですが、今回はデフォルトのままでOKです。

11.コレクションを保存する

ここはデフォルトのままでOKです。

「保存」ボタンを押すと、文章へのインデクシング(索引付け)が走ります。

分析対象となるレコード数やサーバー環境により、インデクシング時間は変動しますが、結構かかるはずですので、別作業を行いながら完了をお待ちください。

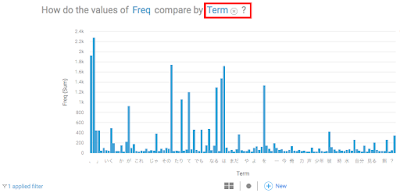

12.完了したコレクションをクリックする

しばらく経つと、下記のように「100%索引付き」と表示されるので、当該コレクションをクリックしてください。

ファセットに合わせて単語の頻度数が表示されました!

次回は、このコレクションを使って、分析機能の詳細をご紹介します。

Watson関連エントリー

Watson Explorerでディズニーの人気作品をテキストマイニング

自動でAIモデルが出来ちゃう〜Watson Studio AutoAI Experiment

SPSS Modeler flowのモデルをWebサービスとしてデプロイする

(無料)Watson StudioでSPSS Modeler flowの決定木を動かす

Watson Studioの「Data Refinery」機能で「馬の疝痛(せんつう)」データを眺めてみた。